亲爱的读者们,你是否曾在机器学习的海洋中迷失方向,寻找那把开启智慧之门的钥匙?今天,我要带你探索一个神秘而强大的领域——集成学习(Ensemble Techniques)。想象将多个模型的力量汇聚在一起,就像把多个小水滴聚成大海,其威力不可小觑。接下来,我们就来揭开集成学习的神秘面纱,看看它是如何让机器学习模型变得更加强大的。

一、什么是集成学习?

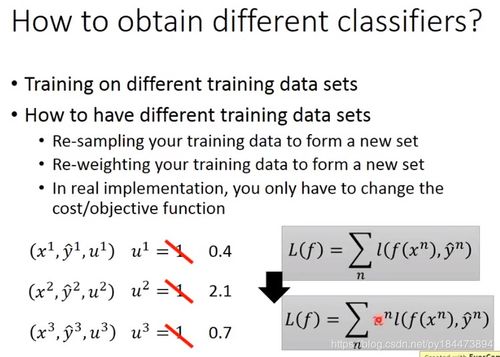

集成学习,顾名思义,就是将多个模型组合在一起,以期获得比单个模型更好的性能。它就像是一个团队,每个成员都有自己独特的技能和特长,当大家齐心协力时,就能发挥出巨大的力量。

二、集成学习的种类

集成学习有很多种方法,下面我们来一一揭晓:

1. 投票集成(Voting Ensembles):这种方法就像是一个民主选举,每个模型都投一票,最终结果由多数决定。适用于分类问题,简单易行。

2. 平均集成(Averaging Ensembles):这种方法就像是一个数学老师,将多个模型的结果取平均值。适用于回归问题,可以降低方差。

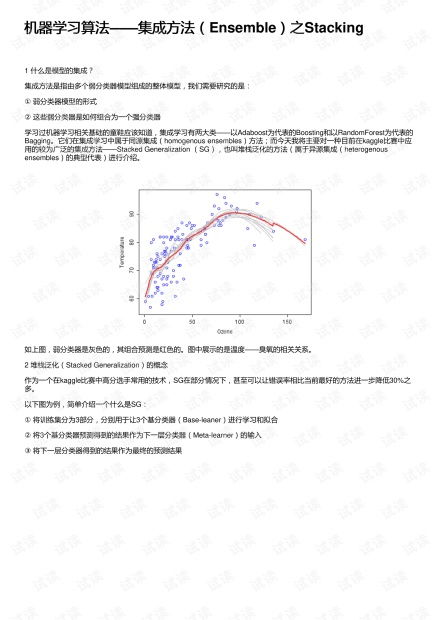

3. 堆叠集成(Stacking Ensembles):这种方法就像是一个层层叠叠的蛋糕,每个模型都负责一层,最后将所有层叠在一起。它需要更多的计算资源,但效果往往更佳。

4. 混合集成(Blending Ensembles):这种方法就像是一个调酒师,将不同类型的酒混合在一起,创造出独特的风味。它结合了多种集成方法,效果更佳。

三、集成学习的优势

那么,集成学习究竟有什么优势呢?

1. 提高准确率:集成学习可以有效地降低过拟合,提高模型的准确率。

2. 增强鲁棒性:集成学习可以降低模型对噪声的敏感度,提高模型的鲁棒性。

3. 泛化能力更强:集成学习可以更好地处理复杂问题,提高模型的泛化能力。

四、集成学习的应用

集成学习在各个领域都有广泛的应用,以下是一些例子:

1. 金融领域:用于风险评估、信用评分等。

2. 医疗领域:用于疾病诊断、药物研发等。

3. 自然语言处理:用于文本分类、情感分析等。

五、集成学习的挑战

当然,集成学习也有其挑战:

1. 计算成本高:集成学习需要训练多个模型,计算成本较高。

2. 参数调优复杂:集成学习需要调整多个参数,参数调优较为复杂。

3. 模型解释性差:集成学习的结果往往难以解释。

来说,集成学习是一种强大的机器学习技术,可以帮助我们解决各种复杂问题。虽然它存在一些挑战,但只要我们掌握其精髓,就能在机器学习的道路上越走越远。让我们一起探索集成学习的奥秘,开启智慧之门吧!